C’est un fait peu connu qu’une partie du nom de Wikipédia vient d’un bus à Hawaï. En 1995, six ans avant le lancement de la célèbre encyclopédie en ligne, un programmeur informatique nommé Ward Cunningham était à l’aéroport international d’Honolulu lors de sa première visite dans les îles. Il était en train de développer un nouveau type de site Web pour aider les concepteurs de logiciels à collaborer, un site que les utilisateurs eux-mêmes pouvaient rapidement modifier à partir d’un navigateur Web. C’était une innovation frappante à l’époque. Mais comment l’appeler ?

« Je voulais un mot inhabituel pour désigner ce qui était une technologie inhabituelle », a déclaré Cunningham à un lexicographe curieux en 2003. « J’ai appris le mot wiki… quand j’ai été dirigé vers la navette de l’aéroport, appelée Wiki Wiki Bus. »

Wiki signifie rapide, et les mots hawaïens sont doublés pour souligner : le bus très rapide. Avec cela, le logiciel de Cunningham avait le son distinctif qu’il recherchait : WikiWikiWeb.

Wikipedia, dont Cunningham n’a pas participé au développement, est l’un des innombrables sites Web basés sur son travail. La seconde moitié de son nom vient du mot encyclopédie, pedia étant le terme grec pour la connaissance : « connaissance rapide ». Pourtant, maintenant, le site connaît un tel succès que sa renommée a éclipsé ses origines, ainsi que le fait qu’une visite fortuite sur une île a donné à l’ère numérique l’un de ses termes les plus emblématiques.

J’aime me plonger dans les origines de nouveaux mots, en particulier autour de la technologie. À l’ère numérique, la technologie peut sembler être un ordre naturel des choses, surgissant pour ses propres raisons. Pourtant, chaque technologie est ancrée dans une histoire et un moment particuliers. Pour moi, l’étymologie met l’accent sur la contingence de choses que je pourrais autrement tenir pour acquises. Sans le sens de ces histoires trop humaines, je suis incapable de voir nos créations pour ce qu’elles sont vraiment : des extensions merveilleuses et imparfaites de la volonté humaine, empêtrées dans toutes sortes de préjugés et de conséquences imprévues.

Je donne des conférences sur la technologie aux adolescents et j’utilise souvent Wikipédia comme incitation à la discussion. Trouvons et améliorons un article pour améliorer Wikipédia, je suggère, et dans le processus, de réfléchir à ce que « mieux » signifie. La réaction de mon public est presque toujours la même. Qu’est-ce que j’entends par améliorer un article ? Ne sont-ils pas tous écrits par des experts ? Non, je dis. C’est tout l’intérêt d’un wiki : les utilisateurs eux-mêmes l’écrivent, ce qui signifie qu’aucune page n’a jamais le dernier mot. Il n’y a pas de réponses définitives et pas de propriété au-delà de la communauté elle-même.

Certains contributeurs au wiki original de Ward Cunningham sont loin d’être élogieux envers Wikipédia précisément parce qu’ils le voient trahir cette intention. En raison de son succès, soutiennent-ils, Wikipédia encourage une illusion d’impartialité et de permanence. Ses pages peuvent devenir des « vérités » autonomes et autoproclamées qui mettent fin au débat ou le restreignent à une caste éditoriale auto-sélectionnée.

Un élan plus important se cache derrière de telles inquiétudes : le passage du temps lui-même. Aucun de mes adolescents ne se souvient d’une époque antérieure à Wikipédia, et le site Web original de Cunningham est plus ancien que tout le monde. d’eux. Comme la plupart des logiciels et du matériel dans leur vie, Wikipédia est simplement une partie du paysage, quelque chose que les gens habitent, s’adaptant à ses contours.

Le numérique entretient un rapport difficile avec le temps. Les anciens formats et plates-formes tombent rapidement en désuétude ; plus récent est par définition meilleur, plus rapide, plus lumineux. Pourtant, des décisions vieilles de plusieurs décennies continuent d’avoir une influence. Si, par exemple, vous voulez comprendre la conception d’une souris d’ordinateur, vous devez vous replonger dans un article de la NASA de 1965 explorant différentes méthodes de contrôle possibles, notamment une sorte de pédale déplacée avec les genoux, une tablette et un stylet « Grafacon », un stylo lumineux, un joystick. En faisant cela, vous vous retrouverez transporté à une époque où il n’était en aucun cas évident de savoir comment les gens pourraient le mieux interagir avec un ordinateur, ou même ce que signifiait interagir avec un ordinateur. Exemple de citation de l’article original : « Bien que le contrôle du genou n’ait été développé qu’à l’époque où il a été testé, il s’est classé élevé à la fois en termes de vitesse et de précision et semble très prometteur.

Qui imaginerait utiliser ses genoux pour contrôler un ordinateur aujourd’hui en parallèle de la frappe, comme travailler sur une machine à coudre à l’ancienne ? Tracer le fil d’un mot est un beau contrepoids à l’obsession souvent implacable de la culture numérique pour le présent, esquissant comment chaque itération de logiciel et de matériel s’appuie sur des idées et des valeurs plus anciennes. Connectez-vous à un réseau sans fil et vous entrez dans le même espace verbal que le télégraphe sans fil développé dans les années 1890. À l’époque comme aujourd’hui, des accords internationaux devaient être établis pour une mise en réseau réussie, ainsi qu’une réglementation, des licences et l’affirmation agressive des normes des marques. Communiquer électroniquement, c’est participer à un vaste consensus négocié, construit et entretenu sur la base de décennies d’hypothèses accumulées.

De même, parler de technologie, c’est assumer : cela demande des notions partagées de sens et d’usage. Pourtant, il y a des termes qui méritent plus de scepticisme que la plupart. Il y a soixante ans, un groupe de scientifiques a élaboré un programme de conférence visant à prédire et à façonner l’avenir, à établir un domaine qui, selon eux, transformerait le monde. Leur mission était d’utiliser la jeune science du calcul numérique pour recréer et dépasser le fonctionnement de l’esprit humain. Leur titre choisi ? Le projet de recherche d’été de Dartmouth sur l’intelligence artificielle.

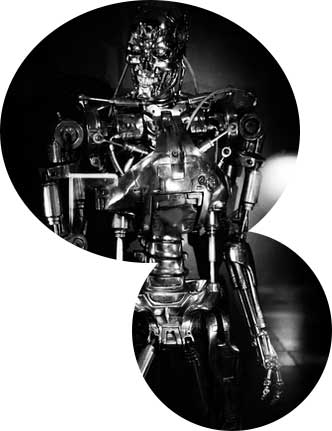

Les hypothèses de la Conférence de Dartmouth, énoncées dans une proposition de 1955, étaient explicitement impudiques : « [L]’étude doit procéder sur la base de la conjecture que chaque aspect de l’apprentissage ou tout autre élément de a décrit qu’une machine peut être faite pour le simuler. Pourtant, aujourd’hui, le mot même «intelligence» continue de se situer quelque part entre une meule et un homme de paille pour ce domaine. Des véhicules autonomes à la reconnaissance faciale, de la maîtrise de Chess and Go à la traduction basée sur le traitement de milliards d’échantillons, une automatisation de plus en plus intelligente est un source de fascination anxieuse. Pourtant, les mots mêmes qui peuplent chaque titre nous éloignent encore plus de la vision des machines telles qu’elles sont – non pas tant un miroir de l’intellect humain que quelque chose de totalement différent de nous, et d’autant plus puissant pour cela.

Comme Alan Turing lui-même l’a dit dans son article de 1950 sur les machines informatiques et l’intelligence, « nous ne pouvons voir qu’une courte distance, mais nous pouvons voir beaucoup de choses qui doivent être faites ». Si nous voulons affronter l’avenir avec honnêteté, nous avons besoin à la fois d’une idée claire d’où nous venons et d’une description précise de ce qui se passe sous notre nez. L’IA, telle qu’elle est, s’étend sur une multitude de disciplines émergentes pour lesquelles des étiquettes plus précises existent : apprentissage automatique, systèmes symboliques, big data, apprentissage supervisé, réseaux de neurones. Pourtant, une analogie vieille de 60 ans fossilisée dans les mots obscurcit le débat autour de la plupart de ces développements, tout en alimentant des fantasmes inutiles à la place de connaissances pratiques.

Même si on peut se faire piéger dans les mots, aujourd’hui reste un âge d’une extraordinaire fertilité linguistique, marquée non seulement par l’alphabétisation de masse, elle-même un phénomène historique récent, mais par la participation massive au discours écrit et enregistré. À travers les écrans de milliards de téléphones portables, tablettes, ordinateurs portables et ordinateurs de bureau, l’humanité est saturée d’expression de soi comme jamais auparavant.

Tous ces mots disent et révèlent plus que nous ne savons, si nous voulons les interroger. L’étymologie insiste sur le fait que tout était autrefois nouveau, bien que né d’une négociation avec tout ce qui l’a précédé. D’une certaine manière, les histoires derrière de nouveaux mots nous interpellent à repenser : récupérer le choc et l’étrangeté de chaque ajout au monde.

Je ne crois pas que connaître l’origine de Wikipédia nous aide particulièrement à comprendre son succès, ou nous apprend à mieux l’utiliser. Mais cela rappelle que les choses n’ont pas toujours été comme elles sont aujourd’hui, suivies, espérons-le, par l’idée que les choses ne seront pas toujours comme elles sont aujourd’hui non plus.

SEO Agence est une agence SEO à Lille.